Джимми Джин/Unsplash

Команда исследователей Apple анонсировала новую систему искусственного интеллекта под названием ReALM (Reference Resolution As Language Modeling). Он не только может понимать неоднозначные ссылки на объекты на экране, но также учитывает разговорный и контекстный фон, обеспечивая более естественное взаимодействие с голосовыми помощниками.

Что известно

ReALM использует крупномасштабные языковые модели для преобразования сложных проблем разрешения ссылок на экран в проблемы моделирования языка. Было показано, что этот подход значительно улучшает производительность по сравнению с существующими методами.

«Способность понимать контекст, включая ссылки, имеет решающее значение для разговорных помощников», — отмечают исследователи Apple. Они продемонстрировали, что ReALM превосходит GPT-4 в этой задаче.

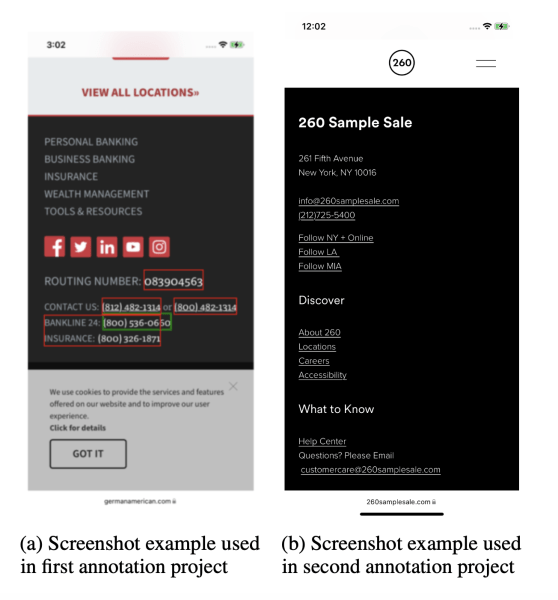

Ключевое нововведение ReALM — преобразование экрана в текстовое представление, передающее визуальное расположение и положение объектов. Это, в сочетании с настройками языковой модели, значительно улучшило разрешение экранных ссылок.

ReALM понимает ссылки на экранные объекты и обеспечивает более естественное взаимодействие с голосовыми помощниками

В этом исследовании подчеркивается потенциал специализированных языковых моделей для решения конкретных проблем в операционных системах, где сложно использовать большие сквозные модели. Публикации Apple сигнализируют о продолжающихся инвестициях в улучшение удобства использования Siri и других продуктов.

Однако авторы предупреждают, что автоматизированный анализ экрана имеет ограничения. Более сложные визуальные задачи могут потребовать компьютерного зрения и мультимодальных подходов.

Пока конкуренты активно внедряют генеративный искусственный интеллект, Apple пытается сократить отставание в этой быстрорастущей области. Ожидается, что компания анонсирует новые функции, основанные на крупномасштабных языковых моделях и искусственном интеллекте, на предстоящей конференции WWDC.

Источник: VentureBeat