Mohamed M/Unsplash

Компания Apple представила облегченные языковые модели OpenELM, способные работать локально на устройствах без подключения к облаку.

Что известно

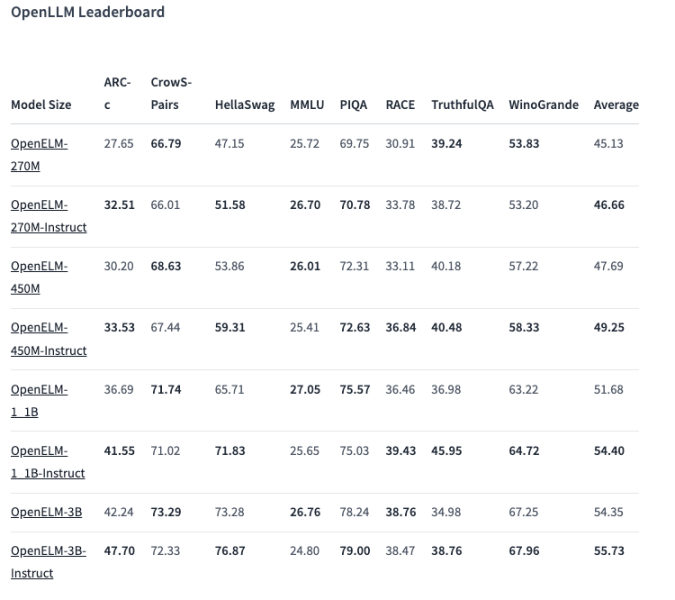

В линейке OpenELM восемь моделей двух типов — предварительно обученные и настроенные по инструкциям. Каждый вариант доступен с 270 млн, 450 млн, 1,1 млрд и 3 млрд параметров.

Модели предварительно обучались на публичных наборах данных из 1,8 трлн токенов с таких сайтов, как Reddit, Wikipedia, arXiv.org и других.

Благодаря оптимизации OpenELM могут функционировать на обычных ноутбуках и даже некоторых смартфонах. Тесты проводились на ПК с Intel i9 и RTX 4090, а также MacBook Pro M2 Max.

По данным Apple, модели демонстрируют хорошую производительность. Вариант на 450 млн параметров с инструкциями особенно выделяется. А OpenELM-1.1B на 2,36% превзошла GPT-аналог OLMo, требуя при этом вдвое меньше лексем для предварительного обучения

В бенчмарке ARC-C, предназначенном для проверки знаний и умений рассуждать, предварительно обученный вариант OpenELM-3B показал точность 42,24 %. В то же время на MMLU и HellaSwag он набрал 26,76 % и 73,28 % соответственно.

Компания опубликовала исходный код OpenELM на Hugging Face под открытой лицензией, включающей обученные версии, бенчмарки и инструкции по работе с моделями.

При этом Apple предупреждает, что OpenELM могут выдавать некорректные, вредные или неприемлемые ответы из-за отсутствия гарантий безопасности.

Источник: VentureBeat