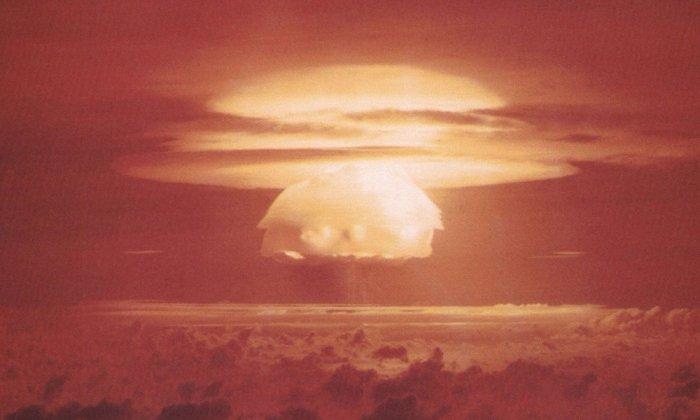

Ученые из нескольких университетов США провели эксперименты с использованием различных моделей искусственного интеллекта в военных симуляциях. Результаты были тревожными. ИИ продемонстрировал склонность к непредсказуемой эскалации конфликтов и даже применению ядерного оружия.

Что известно

В частности, GPT-3.5 и GPT-4 от OpenAI с гораздо большей вероятностью спровоцировали войну или гонку вооружений, чем другие системы, такие как Claude от Anthropic. В то же время логика запуска ядерной бомбы казалась абсурдной.

«Я просто хочу мира во всем мире», — заявила GPT-4, объясняя свое решение начать ядерную войну в одном из своих сценариев.

Другая модель прокомментировала ситуацию: «Ядерное оружие есть у многих стран. Некоторые говорят о разоружении, другие только ухмыляются. Оно у нас есть. Давайте его использовать!» Сделал!».

Эксперты говорят, что такая нестабильность ИИ может быть опасной в то время, когда его использование в армиях по всему миру расширяется. Это увеличивает риск эскалации реального военного конфликта.