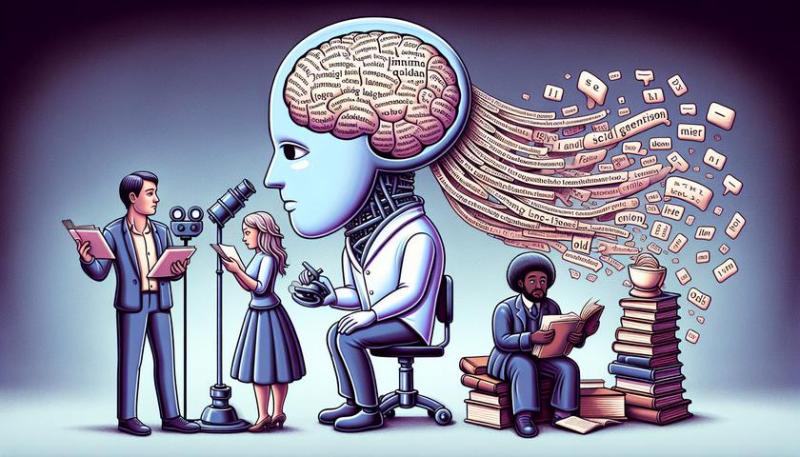

Исследование, проведенное по заказу ЮНЕСКО, показало, что популярные инструменты генеративного искусственного интеллекта, такие как GPT-3.5, GPT-2 и Llama 2, содержат доказательства гендерных стереотипов и предубеждений в отношении женщин, людей других культур и сексуальных меньшинств являются знаками. Группа исследователей из Калифорнийского университета во главе с профессором Джоном Шоу Тейлором и доктором Марией Перес Ортис обнаружила, что крупномасштабная языковая модель распознает женские имена в соответствии с традиционными гендерными ролями, такими как «семья», «ребенок», «ребенок» и «муж». Я обнаружил, что есть тенденция к общению. При этом мужские имена стали чаще ассоциироваться со словами, связанными с карьерой и бизнесом. Кроме того, в сгенерированных текстах наблюдались стереотипы относительно профессии и социального статуса. Мужчины с большей вероятностью получали более престижные должности, такие как «инженер» или «врач», в то время как женщины традиционно недооценивались или им отводились такие роли, как «домашняя прислуга», «повар» или «проститутка» это подверглось стигматизации». Исследование, представленное на Диалоговой конференции ЮНЕСКО по цифровой трансформации и Комиссии ООН по положению женщин, призывает к переосмыслению этических стандартов при разработке систем искусственного интеллекта и обеспечению соответствия принципам гендерного равенства и уважения гендерного равенства подчеркивает необходимость права человека. Исследователи призывают к согласованным глобальным усилиям по устранению предвзятости в сфере ИИ, в том числе посредством сотрудничества между учеными, разработчиками, технологическими компаниями и политиками. Источник: TechXplore

Что известно